蓝鲸资本调仓启示录:清仓Meta、微软,逆势抄底英伟达

当前AI发展正处于从"模型创新"向"规模应用"过渡的关键期,作为"算力军火商"的英伟达兼具确定性和弹性。

4月21日,根据基金经理消息,英国知名对冲基金——蓝鲸资本(Blue Whale Capital LLP)的持仓悄然发生巨变。这家管理规模达13.4亿美元的基金,在清仓Meta和微软两大科技巨头的同时逆势增持英伟达,仓位调整涉百亿美元。

以史为鉴清仓Meta 微软已逼近“资本成本临界点”

对于Meta的清仓决策,蓝鲸资本给出了双重解释框架:直接诱因是2025年4月特朗普政府宣布的全面关税政策可能引发的全球经济放缓。作为数字广告收入占比高达95%的企业(行业平均为60%),Meta的命脉系于全球商业活动的活跃度。

历史数据显示,在2018年中美贸易摩擦期间,Meta广告收入增速曾从49%骤降至26%,这种强周期性特征在关税阴影下被显著放大。更深层的忧虑则来自AI投入与产出的错配——尽管Meta在个性化广告算法和元宇宙场景中持续加码AI,但其2024年研发支出中仅有32%直接转化为营收增长,远低于微软的41%和谷歌的38%(据Saasverse 2024年Q4行业报告)。这种技术投入的"沉没成本效应",在资本眼中构成了难以量化的风险敞口。

微软的离场则指向AI军备竞赛中的财务纪律问题。根据蓝鲸资本内部测算,微软2024年在AI基础设施上的资本支出高达500亿美元,约占其全年经营性现金流的58%。尽管Copilot智能办公套件带来了19亿美元新增收入,但考虑到每用户年均120美元的订阅定价与数据中心建设成本间的回报周期,基金经理Stephen Yiu认为"现金流回报率已从2023年的12.1%下滑至8.5%,逼近资本成本临界点"。

逆市增持英伟达 蓝鲸长期看好人工智能前景

转向英伟达的增持决策,则完美诠释了"别人恐惧时贪婪"的投资哲学。尽管该股在2025年前四个月下跌24%,但其在AI算力市场的统治地位反而愈加稳固——全球90%的生成式AI训练任务依赖其GPU,2024年数据中心收入同比增长126%至476亿美元。

当前AI发展正处于从"模型创新"向"规模应用"过渡的关键期,作为"算力军火商"的英伟达兼具确定性和弹性。从财务指标看,34.52的市盈率虽高于半导体行业平均,但相较于82.2%的资产回报率(ROA)和119.18%的净资产收益率(ROE),估值仍具吸引力。这种"高增长消化高估值"的特性,在资本开支周期中往往能产生超额收益。

据Gartner 2025年一季度报告,全球企业在AI应用层的投资回报周期中位数已延长至5.2年,较2023年增加19个月;而硬件基础设施的边际收益却因算力紧缺持续攀升,英伟达H100芯片的现货溢价在2024年底一度达到官价的300%。

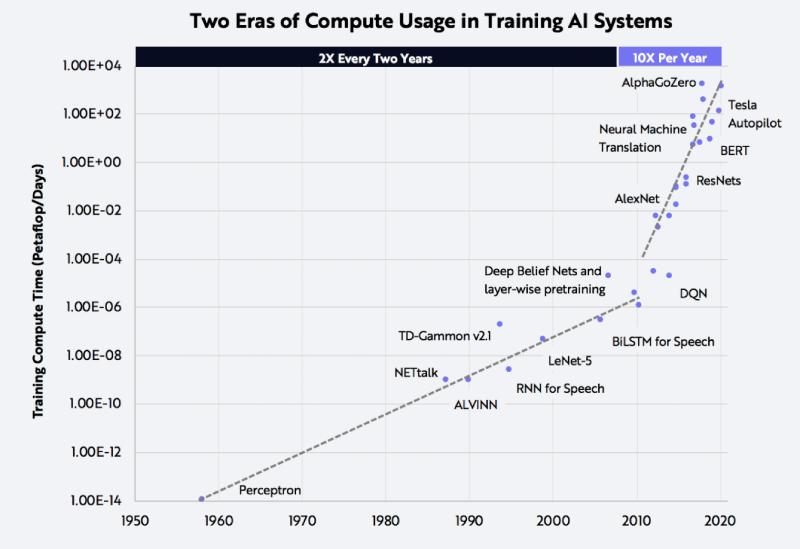

这种分化趋势迫使投资者重新审视"硬件先行"定律——正如1990年代互联网泡沫时期,思科路由器厂商的存活率远高于门户网站。蓝鲸资本的持仓结构调整,本质上是对"算力即权力"产业逻辑的投票,其增持英伟达至组合权重10%的操作,与1999年老虎基金重仓英特尔有着惊人的历史相似性。

根据ARK Invest测算,AI训练成本正以每年50%的速度下降,但推理成本却因模型复杂化保持刚性——这种剪刀差效应使得拥有CUDA生态壁垒的英伟达持续受益,而依赖API调用量的软件企业则面临盈利模型的不确定性。当微软每赚取1美元AI收入需要支付0.3美元给合作伙伴时,英伟达每卖出1美元GPU就能产生0.65美元的毛利润——这种价值捕获能力的差异,最终在资本市场的估值体系中形成断层线。

AI逻辑巨变 普通人如何投资?

从数据来看,半导体行业的增长动能正从消费电子向AI基础设施加速切换。IDC数据显示,2025年全球半导体市场预计增长11%,其中AI相关芯片需求成为核心驱动力,英伟达数据中心业务前三季度同比激增192%即是明证。

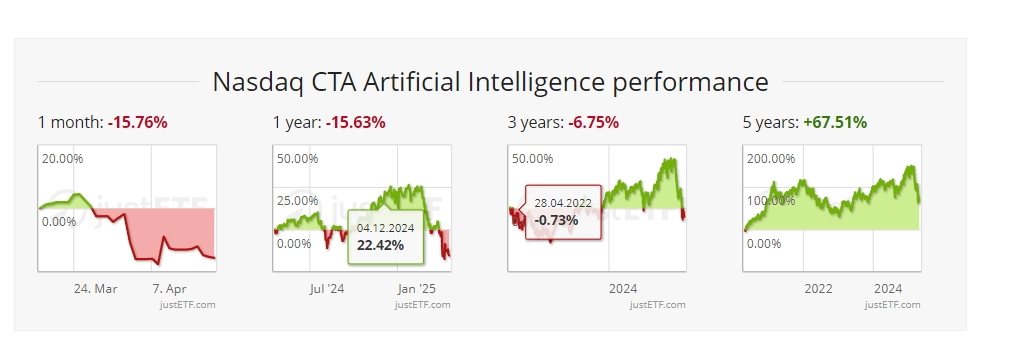

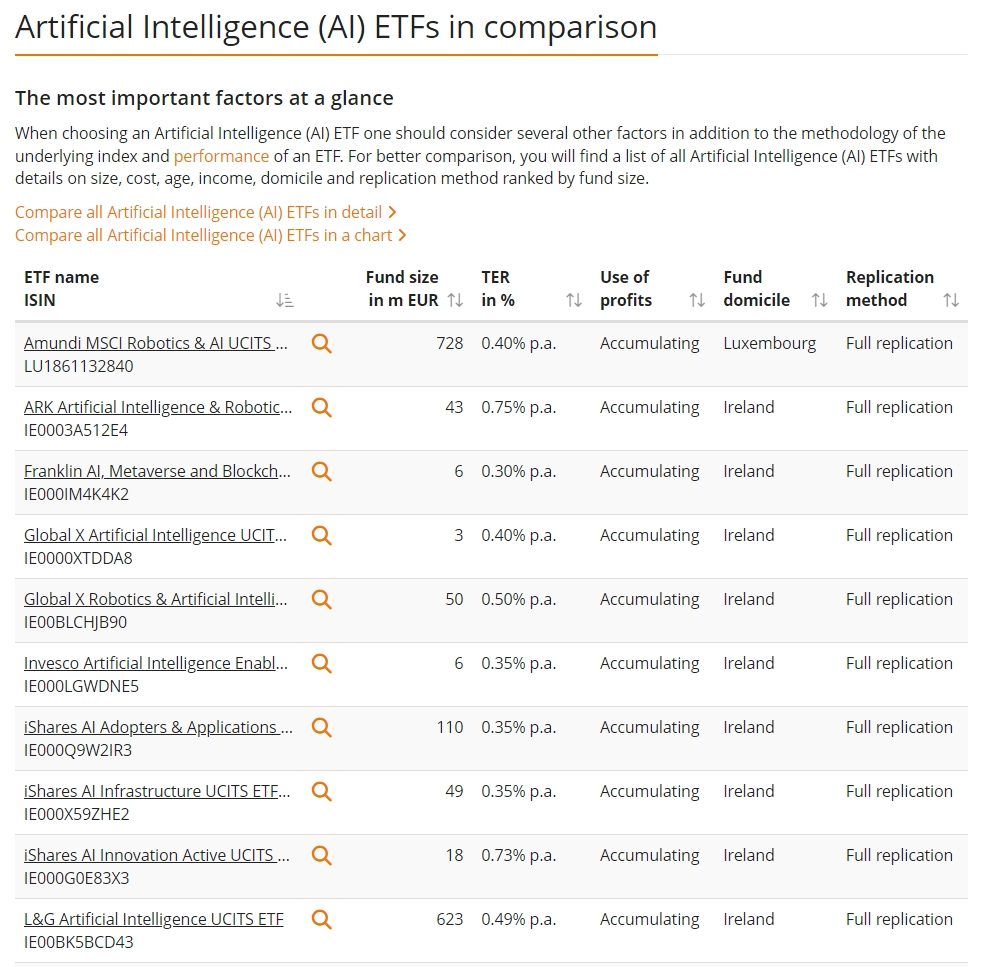

购买半导体,人工智能相关的ETF或许更适合没时间做深度调研、资金量较小的普通人。

因为人工智能概念相关公司股价普遍较高,如英伟达、甲骨文、谷歌、微软、Meta 等,普通投资者持有多只股票的资金成本较高。相比之下,人工智能相关 ETF 具有资金门槛低的优势,一般购买一手(100 份)仅需一百多美元。

ETF 选品丰富,涵盖人工智能产业链上下游企业,投资者无需深入研究个股即可实现风险分散,分享行业发展红利。此外,ETF 不存在停牌或退市风险,即使在熊市也能正常交易,为投资者提供了止损机会。基于其门槛低、交易透明、选品丰富、稳定性高和支持场内交易等优势,ETF 成为普通投资者和新手投资者参与人工智能市场的理想选择。

以下是一些市面上热门的人工智能ETF产品,仅作举例,不作推荐建议:

原本Deepseek的出现,让市场对算力的需求产生一股隐忧。DeepSeek之所以引起恐慌,是因为它展示了一种可能性,即以其他模型成本的一小部分来训练AI模型。这可能会减少对数据中心和昂贵、先进的芯片的需求。但实际上,DeepSeek推动了AI行业去发展资源需求量更大的推理模型,这意味着计算基础设施仍然非常必要。

未来,根据预测,虽然AI未来对计算能力的需求将仅为当前的一小部分,但推理模型在回答用户提问时需求量的增加可能会弥补这一点。随着企业发现新AI模型更强大,它们越来越多地调用这些模型。这将计算能力的需求从训练模型转向使用模型,即AI行业中的“推理”。

风险投资家Tomasz Tunguz表示,投资者和大型科技公司在赌,未来十年中,由于推理模型和AI的迅速普及,对AI模型的需求可能会增加一万亿倍或更多。

这表明,人工智能的大基建时代,还在继续。

·原创文章

免责声明:本文观点来自原作者,不代表Hawk Insight的观点和立场。文章内容仅供参考、交流、学习,不构成投资建议。如涉及版权问题,请联系我们删除。