Meta最新AI芯片亮相 性能比上一代提高了3倍!

Meta表示,早期结果表明,在评估的四个关键模型中,新一代MTIA芯片的性能比第一代芯片提高了3倍。

4月10日,Meta宣布推出新一代训练和推理加速器(MTIA)。MTIA是Meta专为AI工作负载而设计的定制芯片系列。

去年5月,Meta推出了MTIA v1,为该公司的第一代人工智能推理加速器。MTIA v1旨在与Meta的高质量推荐模型完美配合。该系列芯片可以帮助提高训练效率,并使实际的推理任务变得更容易。

Meta表示,新一代MTIA的计算和内存带宽比以前的解决方案增加了一倍多,同时保持了与工作负载的紧密联系。

据官方介绍,新一代MTIA由8x8网格的处理元件(PE)组成。这些PE大大提高了密集计算性能(是 MTIA v1 的 3.5 倍)和稀疏计算性能(提高了7倍)。新一代MTI设计还采用改进的片上网络(NoC)架构,使带宽加倍,并允许以低延迟在不同PE之间进行协调。

为了支持新一代芯片,Meta还开发了一个大型机架式系统,最多可容纳72个加速器。它由三个机箱组成,每个机箱包含12个板,每个板包含两个加速器。

此外,Meta还将加速器之间以及主机与加速器之间的结构升级到PCIe Gen5,以提高系统的带宽和可扩展性。

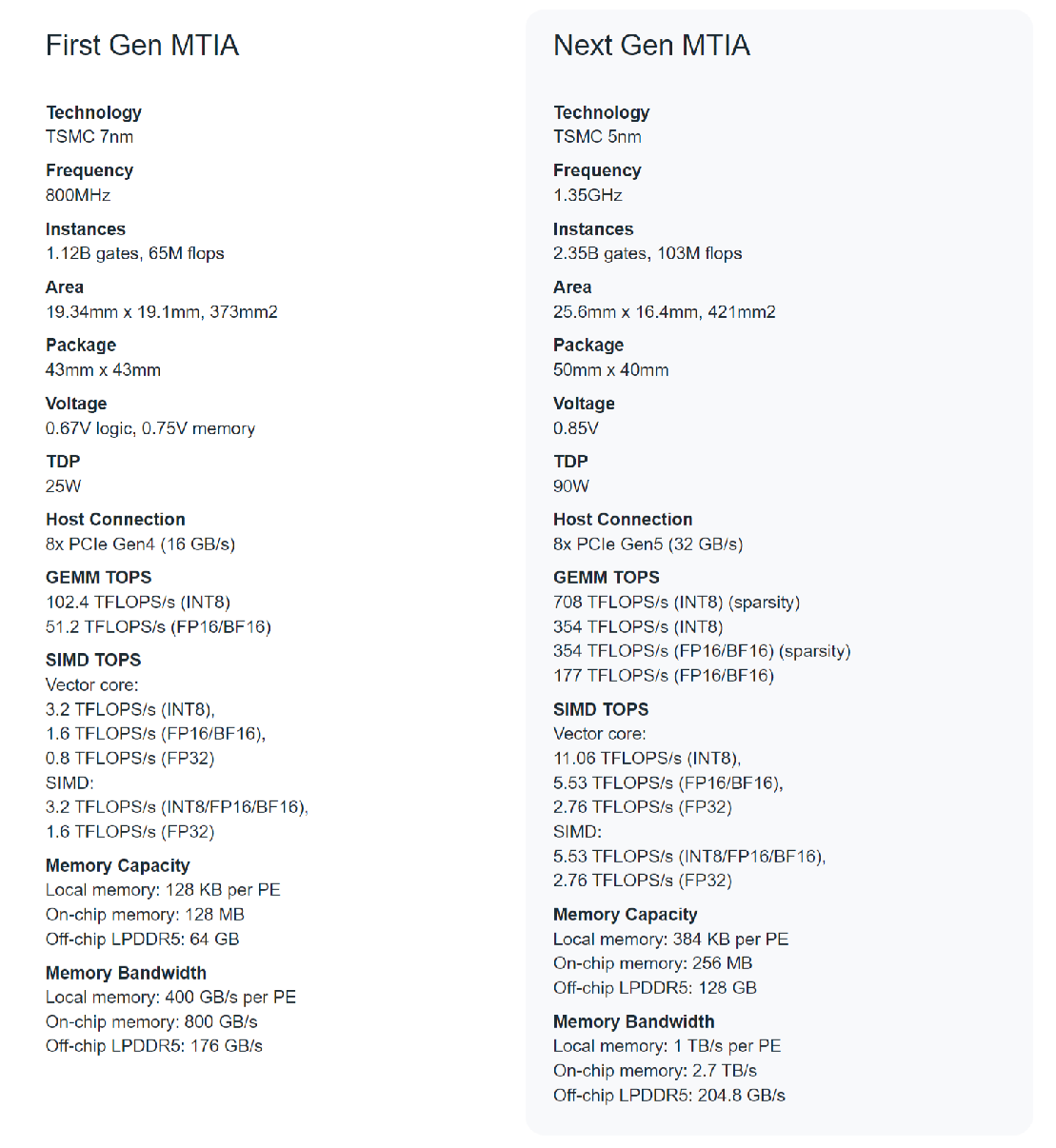

两代MTIA芯片对比来看,新一代MTIA芯片采用的是台积电5nm工艺技术,拥有256MB的片上内存,频率为1.3GHz,而MTIA v1的片上内存为128MB,频率为800GHz,采用的是台积电7nm工艺技术。

新一代MTIA芯片的平均频率达到1.35GHz,比MTIA v1的800MHz要高出不少,但同时它消耗的功率(90W)也要比MTIA v1(25W)高出三倍多。

Meta表示,早期结果表明,在评估的四个关键模型中,新一代MTIA芯片的性能比第一代芯片提高了3倍。在平台层面,通过2倍的设备数量和强大的双插槽CPU,Meta的模型服务吞吐量提高了6倍,每瓦性能比第一代MTIA系统提高了1.5倍。

Meta称:“事实证明,它(指新一代MTIA)在针对特定工作负载提供性能和效率的最佳组合方面与商用GPU具有高度互补性。”

Meta指出,MTIA系列芯片将成为公司的一项长期投资,这些芯片旨在为Meta独特的人工智能工作负载构建和扩展最强大、最高效的基础设施。

Meta还表示,公司内部正在设计定制芯片,以便与其现有的基础设施以及将来可能利用的新的、更先进的硬件(包括下一代 GPU)配合工作。“实现我们对定制芯片的雄心意味着不仅要投资于计算芯片,还要投资于内存带宽、网络和容量以及其他下一代硬件系统。”

不过,Meta并未明确指出该公司目前是否在使用新一代MTIA来处理生成式AI训练工作负载。Meta仅表示,其目前“正在进行多个计划”,以期扩大MTIA的范围,包括对GenAI工作负载的支持。

去年10月,Meta的首席执行官扎克伯格就表示,“人工智能将成为我们2024年最大的投资领域。”并表示,该公司将斥资高达350亿美元用于支持人工智能的基础设施(包括数据中心和硬件)的建设。

虽然Meta野心勃勃,但是在自研芯片方面,Meta面临的来自同行的压力并不小。

去年11月,微软就推出了两款自研AI芯片——Azure Maia 100及Azure Cobalt 100,用以强化Azure AI和Microsoft Copilot服务。

去年底,谷歌在推出新Gemini大语言模型(LLM)的同时,还发布了用于训练人工智能模型的第五代定制芯片TPU v5p。谷歌表示,TPU v5p可以训练像GPT3-175B这样的LLM。在本周,谷歌已经开始向其谷歌云客户推出TPU v5p。目前,Meta还没有MTIA系列芯片量产或推向客户的消息。

·原创文章

免责声明:本文观点来自原作者,不代表Hawk Insight的观点和立场。文章内容仅供参考、交流、学习,不构成投资建议。如涉及版权问题,请联系我们删除。