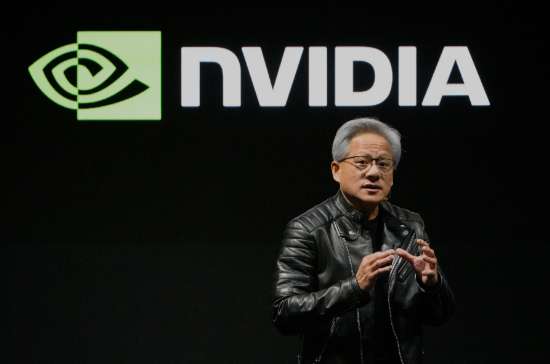

NVIDIA のこの「隠れたビジネス」は、 2 週間で市場の焦点となる

NVIDIA が 8 月 27 日に第 2 四半期の決算を発表すると、投資家はデータセンター事業の業績に注目されます。結局のところ、チップ巨人は収益 g を達成しました

NVIDIA が 8 月 27 日に第 2 四半期の決算を発表すると、投資家はデータセンター事業の業績に注目されます。結局のところ、このチップ大手は高性能 AI プロセッサの販売によってこのセグメントの収益成長を達成しました。

しかし、データセンター部門のビジネスはチップ販売をはるかに超えています。また、 NVIDIA の見落とされがちですが重要な製品、すなわちネットワーク技術も含まれています。

NVIDIA のネットワーキングポートフォリオには、 NVLink 、 InfiniBand 、 Ethernet ソリューションが含まれています。これらのソリューションは、チップ同士の通信を可能にし、大規模なデータセンター内のサーバーを接続し、最終的にエンドユーザーが AI アプリケーションを実行するためのすべてにアクセスできるようにする技術です。

NVIDIA のネットワーキング担当シニアバイスプレジデントである Gilad Shainer 氏は、「スーパーコンピュータを構築する上で最も重要な部分はインフラストラクチャです。最も重要な部分は、それらのコンピューティングエンジンをどのように接続して、より大きなコンピューティングユニットを形成するかです。

これは実質的な販売に変換された。昨会計年度、 NVIDIA のデータセンターの総収益は 1,151 億ドルに達し、ネットワーキングの売上高は 129 億ドルを占めました。この数字は、チップ販売の 1,021 億ドルと比較して控えめに見えますが、 NVIDIA の第 2 位のビジネスセグメントであるゲーム部門の年間売上高 113 億ドルを上回っています。

第 1 四半期の NVIDIA のデータセンター売上高は 391 億ドルで、ネットワーキングは 49 億ドルを占めました。また、研究大学や大規模データセンターを問わず、お客様が AI コンピューティング能力を拡大し続ける中で、ネットワーキングはさらなる成長の準備ができています。

Deepwater Asset Management のマネージングパートナーの Gene Munster 氏はインタビューで、「ネットワークは、収益の 11% を占めるため、基本的に注目されていません。ロケット船のように成長している」と。

何千ものチップの接続

NVIDIA のネットワーキング担当シニアバイスプレジデントである Kevin Deierling 氏は、 AI ブームの時代において、同社は 3 つの異なるタイプのネットワーキングに取り組まなければならないと説明しました。1 つ目は、大型ラックマウントシステムのサーバ内または複数のサーバ間で GPU を接続し、通信し、全体的なパフォーマンスを向上させることができる NVLink テクノロジーです。

次に、データセンター内の複数のサーバーノードを接続し、 1 つの大規模な AI コンピュータを形成する InfiniBand です。次に、イーサネット接続に依存するストレージとシステム管理のためのフロントエンドネットワークがあります。

しかし、これらの接続の目的は、チップとサーバの通信を助けるだけではありません。これらのデバイスが可能な限り高速でデータ交換できるように設計されています。サーバのクラスタを単一のコンピューティングユニットとして実行しようとする場合、それらの通信は瞬時に発生する必要があります。

GPU への不十分なデータフローは、計算プロセス全体を遅らせ、他の操作を遅らせ、データセンターの全体的な効率を低下させます。

Munster 氏は、「 ( NVIDIA は ) ネットワーキングなしで非常に異なるビジネスです。すべての NVIDIA チップを購入している人々が望む出力は、ネットワークがなければ実現しません。"

また、企業がユーザーのためにタスクを実行できる自律 · 半自律エージェントとともに、より大きな AI モデルを開発し続ける中で、これらの GPU が調和して動作することを保証することはますます重要になっています。

これは、 AI モデルを実行するプロセスである「推論」が、より強力なデータセンターシステムを要求するため、特に当てはまります。

推論の重要性の増大

AI 業界は、推論の概念を中心とした大きな変化を遂げています。AI ブームの初期には、 AI モデルの訓練には超強力なスーパーコンピュータが必要だと考えられていましたが、実際にはこれらのモデルの実行には比較的控えめな計算能力が必要でした。

今年初め、 DeepSeek は非トップレベルの NVIDIA チップを使用して AI モデルを訓練したと主張し、ウォール街の懸念を引き起こした。当時は、企業が AI モデルを低性能のチップで訓練して実行できれば、 NVIDIA の高価な高性能システムは必要ないと考えていました。

チップ企業は、 AI モデルは高性能 AI コンピュータでより良い性能を発揮し、劣ったシステムよりも多くの情報を高速に処理すると指摘したため、この議論はすぐに暴露されました。

「エージェントワークフローになるにつれて、トレーニングのように見え始めています。これらのネットワークは重要です。CPU 、 GPU 、 DPU ( データ処理ユニット ) と緊密に結合した、これらすべてが推論を良い体験にするために極めて重要です。

しかし、 NVIDIA の競争相手は旋回しています。AMD はより多くの市場シェアを獲得しようとしています。一方、 Amazon 、 Google 、 Microsoft などのクラウド大手は独自の AI チップを開発し続けています。

Forrester Research のアナリストである Alvin Nguyen 氏は、 NVLink の直接的な挑戦者である UALink を含む業界グループも競合するネットワーク技術を持っていると指摘した。

しかし、今のところ、 NVIDIA はリードのままであります。ハイテク大手、研究機関、企業が NVIDIA のチップを争い続ける中、ネットワークビジネスは成長し続けることはほぼ確実です。

免責事項: この記事の見解は元の著者の見解であり、Hawk Insight の見解や立場を表すものではありません。記事の内容は参考、コミュニケーション、学習のみを目的としており、投資アドバイスを構成するものではありません。著作権上問題がある場合は削除のご連絡をお願い致します。